- BERTとは

- Bidirectional Encoder Representations from Transformers(BERT)は、Googleによって開発された、自然言語処理(NLP)の事前学習用ためのTransformer ベースの機械学習手法。 BERTは、Google のJacob Devlin と彼の同僚によって2018年に作成され公開された。2019年現在 、Googleは BERTを活用して、ユーザー検索の理解を深めている。BERTの起源は、半教師ありシーケンス学習 、生成的事前トレーニング、 ELMo 、 ULMFitなどの事前トレーニングコンテキスト表現にある 。従来のモデルとは異なり、BERT は、プレーンテキストコーパスのみを使用して事前にトレーニングされた、双方向の教師なし言語表現である。 word2vecやGloVeなどの文脈自由モデルは、語彙の各単語に対して単一の単語埋め込み表現を生成する。BERTは、特定の単語の出現ごとにコンテキストを考慮する。たとえば、word2vec では「He is running a company」の「running(経営する)」も「He is running a marathon」の「running(走る)」も同じベクトル表現にしてしまうが、BERT ではコンテキスト化された埋め込みを行い、文によって異なるということになる。

- >> MEOでは「Googleの検索エンジンのアルゴリズムのこと」を指します

タップできる見出し

略歴/流れ

BERTが開発された背景には、Google検索での検索キーワードの多様化があります。

今までの場合は、Googleで検索される事柄は2キーワードのクエリが多く、キーワード間の関係性の把握が簡単なものが多かったです。

しかし、最近は検索キーワードが複雑化かつ多様化しています。

この背景には、検索手法の変化によってキーワードではなく、文章での検索が増えてきたことも大きいです。

最近では、音声入力などが発達してきて、文章として検索されることも多くなっています。

しかし、音声入力される文章のように複雑な構文把握が必要になる場合に、今までのGoogle検索のアルゴリズムでは必要とする情報を提供できないことも多かったです。

そこで、キーワード間の構文把握が得意で、検索をした人が求めている情報を正確に提供できるアルゴリズムを開発するためにBERTプロジェクトが開始されました。

BERTって結局なに?

BERTとは簡単に言うと、今までの検索アルゴリズムでは把握できなかった文章構造を理解して情報を提供できるアルゴリズムのことです。

今までの検索アルゴリズムと比較して、文章の理解度が大幅に向上し、文章を構造化し、その構造を把握することで今までの検索エンジンではできなかった文章理解をすることが可能になりました。

関連する単語の紹介

NLP

NLPとは、自然言語処理のことを指します。

NLPは、BERTの前に検索エンジンなどで使用されており、キーワード間の関係性を見抜くことが難しいとされていました。

SoTAモデル

SoTAモデルとは、state of the artモデルの略称で最先端モデルのことを指します。

BERTを含めて、ここ最近開発されたアルゴリズムやモデルに関しては、新しいという意味を込めてSoTAモデルと言われることが多いです。

ERNIE

ERNIEとは、BERTを改良して中国語専用で作成されて自然言語処理技術です。

BERTのメリットや活用

ここでは、BERTのメリットや活用を検索エンジンを利用する読者とコンテンツ作成者の2人の目線から紹介します。

読者から見たBERTのメリット・活用

Google検索のアルゴリズムにBERTが採用されたことで、検索をする読者はより自分の求めている情報にクリティカルにヒットすることが可能です。

また、今までの検索エンジンでは文章から的確な情報を表示するのが難しかったですが、BERTが導入されたことで文章からの構文把握を行い求めている情報を提供することができます。

そのため、読者が検索したい事柄を検索窓に入力して、そこから自分の探している情報が掲載されているページを自分で探す手間を省くことが可能です。

コンテンツ作成者から見たBERTのメリット・活用

コンテンツ作者者から見たBERTのメリットは、ドメインパワーにかかわらず、情報の内容で上位に表示できるということです。

今までの検索アルゴリズムの場合は、「英語以外の参考書おすすめ」と検索した場合に、「英語」の「参考書」を掲載しているサイトが上位に表示されることがほとんどでした。

しかし、BERTになったことで「英語以外」「参考書」「おすすめ」の記事を執筆しているページが上位に表示されるようになります。

そのため、内容をもとに上位表示を獲得することが可能です。

また、この流れを汲んで今後はさらにロングテールキーワードや複数キーワードのクエリでの検索が増えてくることも予想されます。

MEOにおける優位点・メリット・注意点

BERTは、MEOにおけるメリットはユーザーの求めるものを正確に提示できるということ。

BERTでは、今までのアルゴリズムと異なりより正確なキーワードでの検索が可能になり、検索をした人が求めているものを正確に提示することができるアルゴリズムです。

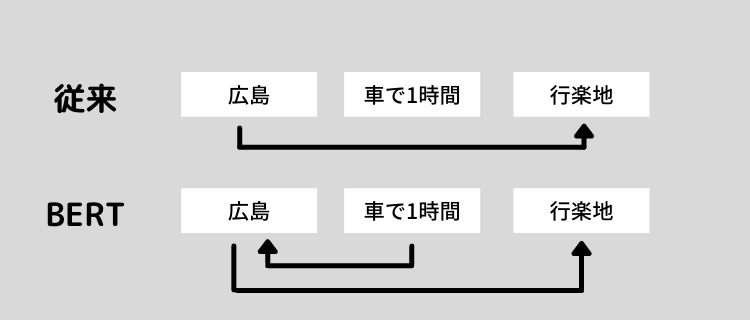

BERTというアルゴリズムは、今までの自然言語処理とは異なり双方向でキーワードを認識することができます。

どういうことかと言うと、今までの検索エンジンの自然言語処理システムではキーワードごとに判断をして、検索した人が求めていた情報を提供していました。

そのため、文章などの複雑な構文がある場合に正確に情報を表示できていないことも多かったです。

しかし、BERTでは双方向でキーワードを認識することが可能になり、より正確な情報を読者に提供することができています。

たとえば、今までの自然言語処理の場合は「広島から車で1時間で行ける行楽地」というキーワードで検索をした際に、「広島」「車で1時間」「行楽地」というキーワードの関係性を見抜くことができず、「広島」の「行楽地」が検索結果に表示されることもありました。

一方で、BERTの場合は「広島」「車で1時間」「行楽地」の関係性を見抜いて、広島県内の行楽地ではなく、広島から1時間で行ける隣県の行楽地を表示することができます。

このように、キーワード間の関係性を見抜いて、どのキーワードに対してどこのキーワードがかかっているのかを自然言語処理で判断をすることで、より検索した人が求めているものを表示することが可能になりました。